英伟达发布AI芯片GH200,黄仁勋称“它会疯狂推理”

英伟达当地时间周二在洛杉矶举行的SIGGRAPH大会上宣布了一项人工智能芯片的新配置,英伟达创始人CEO黄仁勋表示,新的芯片能加速生成式人工智能应用程序,并降低大模型的运行成本,让数据中心规模化。

这款最新发布的人工智能芯片GH200使用与英伟达当前最高端的AI芯片H100相同的GPU,但配备141GB的内存以及72核的ARM芯片,H100的内存为80GB。

“这款芯片是为全球数据中心的横向扩展而设计的。”黄仁勋在发布会上表示。

黄仁勋还表示,新的芯片将于明年第二季度起通过英伟达的经销商供货,并在今年年底前提供样品。但目前这款芯片的价格仍未公布。

英伟达副总裁Ian Buck在一场媒体发布会上表示,新版本的芯片增加了高带宽内存的数量,这种设计能够驱动更大的AI模型运行。GH200经过优化,可以执行AI推理功能,从而有效地为类似ChatGPT等生成式AI应用程序提供支持。

英伟达发布新型芯片的背景是人工智能大模型的规模正在不断扩大。“随着模型参数的增加,它们需要更大的内存才能在不相互连接的单独芯片系统上运行,额外的内存提高了GPU的性能。”Buck说道。

目前英伟达在人工智能芯片市场占据主导地位,据估计市场份额超过80%。例如支持谷歌的Bard和OpenAI的ChatGPT运行的都是英伟达的GPU。而随着全球的科技巨头、云服务提供商和初创公司都在抢夺GPU资源来开发自己的人工智能模型,英伟达的芯片供不应求。

通常,使用人工智能模型的过程至少分为两个部分:训练和推理。首先,使用大量数据训练模型,这个过程可能需要数月时间,有时需要数千个GPU;然后,模型在软件中使用推理来进行预测或生成内容。与训练一样,推理的计算成本很高,并且每次软件运行时都需要大量处理能力。且与训练不同的是,推理几乎持续进行,而训练只有当模型需要更新时才需要重新进行。

“你几乎可以在GH200上运行任何你想要的大型语言模型,它会疯狂地进行推理。”黄仁勋说,“大型语言模型的推理成本将大幅下降。”

英伟达还发布了一个系统,将两个GH200芯片组合成一台计算机,适用于更大的模型。黄仁勋称之为“全球最大的单体GPU”。

在人工智能芯片供不应求之际,上周英伟达的主要竞争对手AMD发布了一款AI芯片MI300X,该芯片可支持192GB内存,并具有AI推理能力。谷歌和亚马逊等公司也在设计自己的定制人工智能推理芯片。

英伟达发布会的另一个亮点为OpenUSD的相关进展。OpenUSD近期由美国3D内容行业的5家主要公司:苹果、英伟达、皮克斯、Adobe和Autodesk联合成立,目标是有一天可能成为“元宇宙”的3D图形标准。该组织正通过促进3D工具和数据更大的互操作性,使开发者和内容创作者能够描述、编写和模拟大型3D项目,并构建范围不断扩大的3D产品和服务。

今年的SIGGRAPH上,IBM高级副总裁Darío Gil的主题演讲涉及量子计算的未来以及它如何帮助解决实际问题。索尼首席技术官Hiroaki Kitano也在SIGGRAPH上主持一个关于电影创意产业的论坛。

SIGGRAPH也一直是展示在混合虚拟现实(XR)研究前沿的场所,今年也不例外。Meta展示了两款VR和MR头戴设备,其中一款是Butterscotch Varifocal,它将变焦技术与视网膜分辨率VR显示相结合;另一个是Flamera,这是一款计算相机,使用光场技术。Butterscotch Varifocal和Flamera均仍处于Meta的研发阶段,但这些技术可能会在未来激发电子消费产品的灵感。

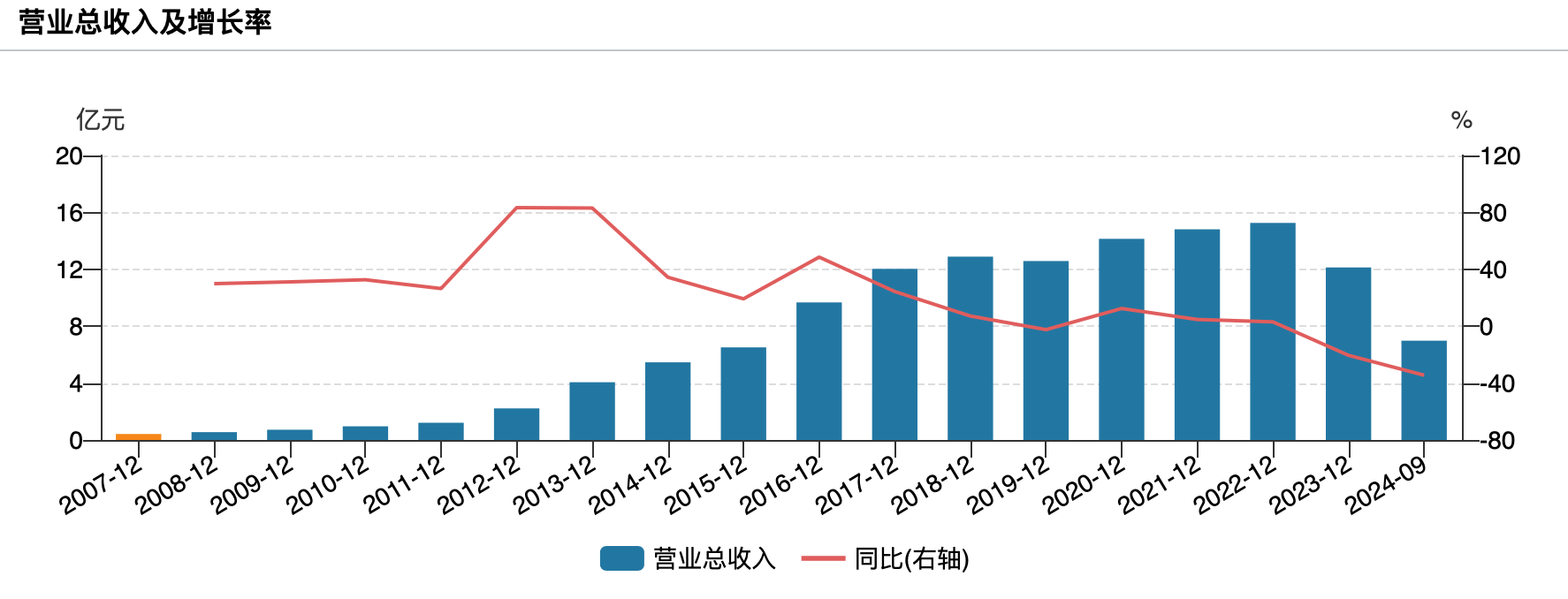

中兴通讯回应股价闪崩:公司经营正常

中兴通讯对第一财经表示,公司经营正常。8月7日,中兴通讯(SZ000063,股价36.75元,市值1758亿元)股价午后加速跳水,尾盘一度触及跌停,最终收报36.75元/股,跌幅达9.97%;港股方面,中兴通讯(HK00763,股价26.95港元,市值1289亿港元)跌幅一度跌超10%,截至今日收盘跌幅为5.77%。锤子财富2023-08-07 20:14:520000网游新规发布游戏板块反应强烈,业内预计征求意见稿将会进一步适应性修改

“网游新规的本意是促进行业健康发展。周六官方回应是及时的,会继续征求企业用户、消费者等方面的意见,不会对行业发展产生大的影响。”有了解办法制定过程的相关人士对第一财经表示,第十七、十八条预计还会有适应性修改。酝酿已久的网游新规一经公布即引发市场热议,A股、港股游戏板块反应强烈。0000空头大举压境!担忧之墙或成为美股新隐忧

美债抛售潮下经济阴云笼罩。美联储9月议息会议结束后,对联邦基金利率更长时间处于高位的恐慌情绪令美国三大股指跌向近三个月低位。机构统计数据显示,随着中长期美债收益率上升,衍生品市场上空头正在大举加仓。展望未来,在季节性弱势的背景下,美联储政策预期和由此带来的经济不确定性恐成为市场进一步波动的导火索。对冲基金加速做空锤子财富2023-09-26 09:48:080000刘俏:怎样释放中国经济长期增长的潜能丨如何理解中国经济系列之二

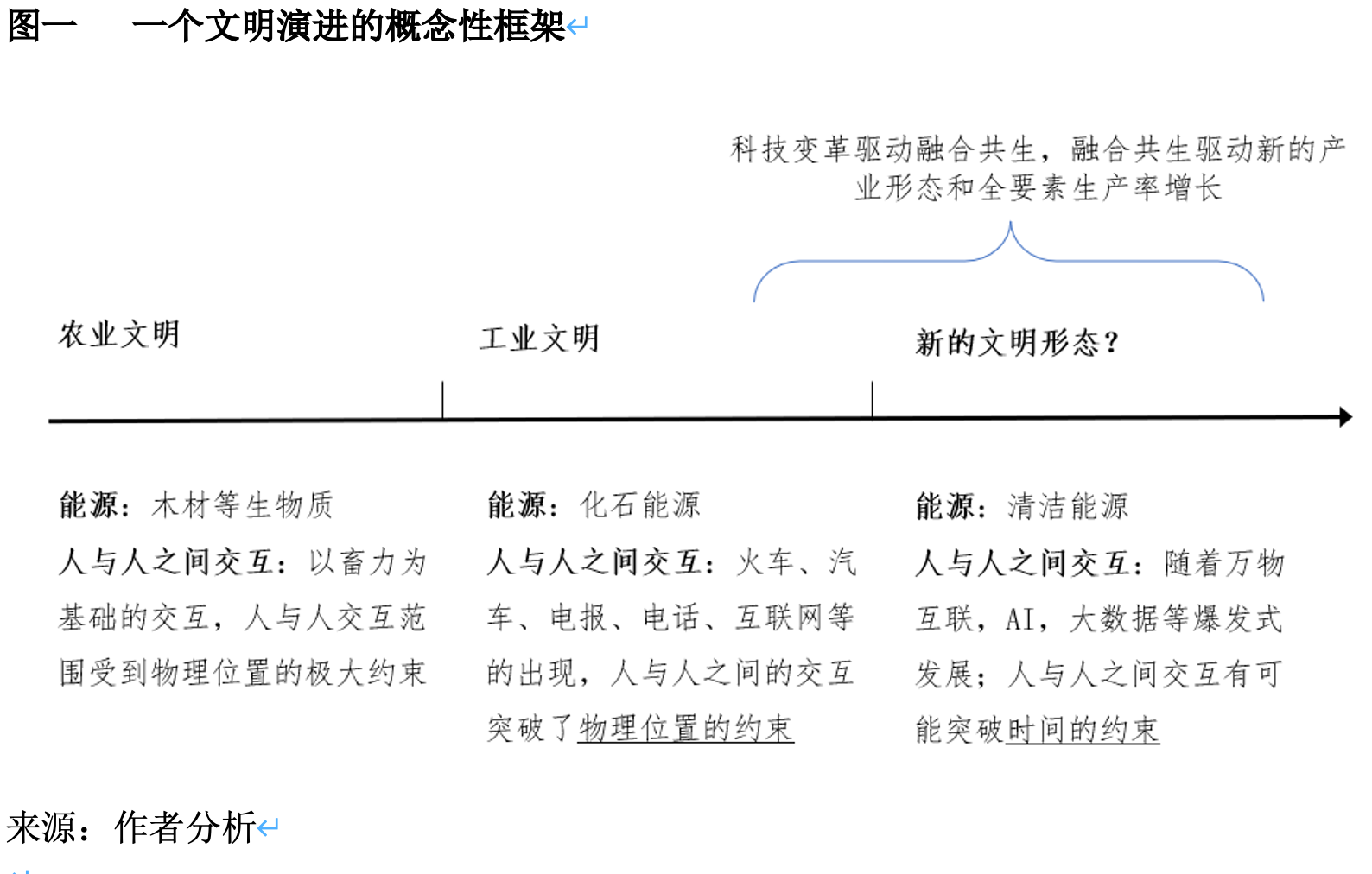

保持节点行业的投资强度甚至超前投资、保持制造业增加值的GDP占比并提升中高端制造业比重、加大基础研究投入推动中国在全球价值链位置向上游迈进。编者按锤子财富2023-08-14 22:44:570000社论:建立沟通交流机制,将为民企解困落到实处

根据今年前五个月的工业经济效益月度报告,全国规模以上工业企业实现利润总额同比下降18.8%。而民营企业的利润下滑幅度首当其冲,下降了21.3%,这充分说明民营企业当前处境艰难。这种现象需要正视。0000