阿里云开源通义千问14B模型,想把AI社区生态先建起来

9月25日,阿里云开源通义千问140亿参数模型Qwen-14B及其对话模型Qwen-14B-Chat,免费可商用。用户可从魔搭社区直接下载模型,也可通过阿里云灵积平台访问和调用。

据了解,Qwen-14B是一款支持多种语言的高性能开源模型,相比同类模型使用了更多的高质量数据,整体训练数据超过3万亿Token,使得模型具备更强大的推理、认知、规划和记忆能力。Qwen-14B最大支持8k的上下文窗口长度。

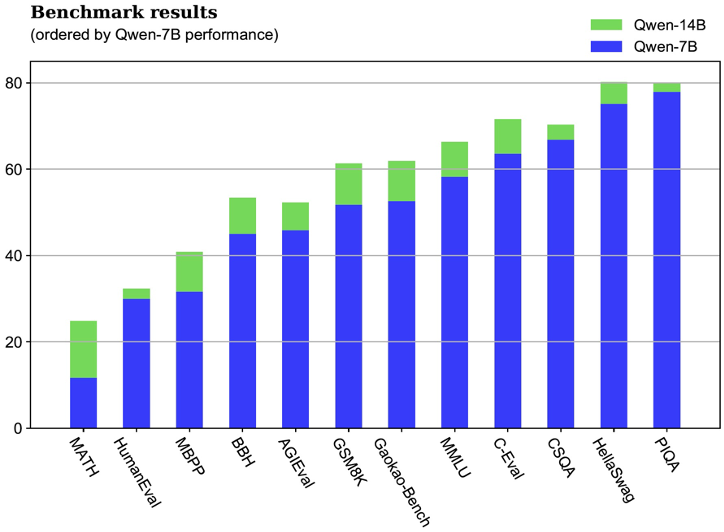

阿里云方面表示,Qwen-14B-Chat是在基座模型上经过精细的监督式微调SFT(Supervised Fine Tuning)得到的对话模型。借助基座模型强大性能,Qwen-14B-Chat生成内容的准确度大幅提升,也更符合人类偏好,内容创作上的想象力和丰富度也有显著扩展。同时,Qwen-14B进一步提高了小尺寸模型的性能上限,在MMLU、C-Eval、GSM8K、MATH、GaoKao-Bench等12个权威测评中取得优秀成绩,超越所有测评中的SOTA(State-Of-The-Art)大模型,也全面超越Llama-2-13B,比起Llama2的34B、70B模型也并不逊色。

此前,8月3日,阿里云将70亿参数的通义千问模型开源,包括通用模型Qwen-7B和对话模型Qwen-7B-Chat。阿里云方面透露,Qwen-7B等模型在魔搭社区上线后,一个多月下载量破100万。随着Qwen-14B的开源,Qwen-7B也全新升级,核心指标最高提升22.5%。

阿里云智能集团首席技术官(CTO)周靖人在接受采访时介绍,Qwen-14B和Qwen-7B处于不同量级,相比此前开源的Qwen-7B,Qwen-14B的整体容量在增加,推理、算数等各种能力也会有所增强,在12个权威测评中的结果也有全面提升。

不过,周靖人表示,两个开源模型对开发者来说并没有二者谁更好的问题,他强调,对阿里云来说,不同尺寸的模型服务是给企业更多的选择,不同版本的模型有不同的优缺点,例如性能极致的模型可能成本较高,企业和开发者需要根据自身需求去选择。

在阿里云的大模型策略方面,周靖人强调阿里云对生态的重视。“让算力更普惠、让AI更普及是阿里云的初衷,把AI发展方方面面的能力真正带到应用层面是阿里云的目标。”在谈及阿里云在开源和闭源方面的布局,周靖人指出,阿里云将坚定不移地做开源,让技术成果更多地集成到业务上,和行业一起为模型的快速应用能够产生实际的使用价值而奋斗,同时也会做更多前沿的研究,包括通义千问等更多产品会陆续推出,把更多能力带给行业。

在大模型的商业化和生态建设方面,周靖人明确,阿里云会先注重生态,然后再关心商业化,希望先把AI社区生态建设起来。他认为,包括微软在内的许多行业玩家也最终会回到生态建设这条道路上来。

阿里云方面的数据显示,魔搭社区的模型累计下载次数已超过8500万次,近一半的下载是在最近两个月发生的,魔搭社区目前已有1200多个大模型,活跃用户超过230万。从模型社区的活跃度来看,大模型有着广阔的市场空间。

个人养老金制度将推进全面实施

人力资源社会保障部表示,下一步将积极推进养老保险全国统筹,确保养老金按时足额发放;持续扩大企业年金覆盖面。记者24日从人力资源社会保障部举行的新闻发布会上获悉,在36个城市及地区先行实施的个人养老金制度,目前运行平稳,先行工作取得积极成效。下一步将推进个人养老金制度全面实施。0000机构解读来了!鲍威尔称3月不太可能会降息,透露哪些信号?丨火线解读

机构认为,美联储首次降息时点或在年中前后,缩表或在3月之后开始减速,年中至三季度结束缩表,但需关注就业市场意外走弱可能给政策进程带来的扰动。预计美元指数和美债利率将保持震荡,短期来看,利空美债的因素已基本落地,而美股则需关注近期财报情况。美国联邦储备委员会1月31日结束为期两天的货币政策会议,宣布将联邦基金利率目标区间维持在5.25%至5.5%之间不变,并暗示暂时不会降息。00001月社融新增6.5万亿历史同期最高,信贷投放节奏更加平稳

2024年“均衡投放”将成为关键词。2月9日,央行公布最新数据显示,2024年1月社会融资规模增量为6.5万亿元,比上年同期多5061亿元。1月份人民币贷款增加4.92万亿元,同比多增162亿元。0000中央汇金加大增持ETF,市场情绪得到修复

中长期机构资金的持续入市,还有助于优化投资者结构,引导市场投资方向,形成实体经济与资本市场互相促进的良性循环。受“国家队”增持等利好因素影响,2月6日,A股三大指数低开后快速反弹。截至发稿,沪指盘中涨超1%,深证成指、创业板指双双涨逾3%,北证50一度大涨超6%。0000险资松绑,送来多少“活水”?最高可释放增量资金2000亿

业内人士分析,偿付能力和考核周期是限制险资入市的主要约束之一,而将保险公司投资沪深300、科创板等风险因子调低,有利于降低保险公司投资这几类权益资产的资本占用,为保险公司松绑,释放出更多权益资产配置空间。险资“松绑”,送来多少“活水”?0000