AI监管各国思路差异较大,全球合作进展缓慢

2023年是人工智能(AI)技术创新与应用突飞猛进的一年,以ChatGPT为代表的生成式人工智能(Generative AI)的涌现意味着人类离通用人工智能(AGI)的实现又进了一步。但同时,AI技术应用及各大科技企业之间激烈的技术竞争也引发了各界对于伦理、安全等问题的不安。

面对这样充满巨大潜力与风险的技术,全球各国与国际层面开始采取行动试图平衡创新与安全。目前中国、美国、欧盟、加拿大、英国、日本、巴西、新加坡等经济体正在起草或准备推出人工智能指导准则或法案,英国AI安全峰会等会议的召开也试图推动人工智能安全治理国际合作。

值得注意的是,各国对于AI监管的原则与方式仍存较大差异,且由于AI政策与地缘政治、经济竞争等因素紧密交织,全球层面的AI监管合作仍未取得具体成果。这可能导致全球人工智能监管政策的碎片化,增加相关企业合规成本并阻碍创新,也可能产生监管漏洞从而导致人工智能风险扩散。

AI的潜在风险与监管的多重挑战

关于AI技术的潜在风险,全球技术专家存在不同看法,这也反映在各国AI监管的不同侧重点上。这些意见主要分为三派:

第一派观点关注AI的长远影响,认为未来可能会诞生超级人工智能,对人类生存构成威胁;

第二派观点关注AI对当下的现实影响,认为AI系统已经加剧了对性别种族的歧视、对弱势群体的压迫、仇恨言论与假新闻的传播等问题;

第三派观点关注AI技术竞争与国家安全问题,认为AI技术若被恶意利用,势必威胁国家安全,而一旦其他国家取得先机,将会削弱本国竞争优势。

对于AI监管面临的困难与挑战,布鲁金斯学会访问学者、美国联邦通信委员会原主席汤姆·惠勒将其归纳为三个方面:

第一,监管速度。考虑到AI技术惊人的进步与迭代速度,监管速度能否跟上成为一大难点。一方面,AI技术发展已经超出政府现有专业知识范围,监管部门需要吸纳更多专业人才以更好理解、识别并评估技术风险;另一方面,现有监管规则普遍并不灵活,需要转向更加敏捷的监管方式。

第二,监管范围。AI技术具有多样的应用场景,“一刀切”式监管往往会在某些情况下导致过度监管或监管不足,因此AI监管必须以具体风险为基础,针对性实施。此外,监管力量不仅需要防止AI用于诈骗等非法活动、处理屡见不鲜的数字滥用,还需应对可能给人类带来的任何有害的未知因素。

第三,谁来监管以及如何监管。谁来监管涉及是基于现有制度还是构建新制度监管的问题,如何监管则涉及具体方式:数字时代需要避开工业式运营、拥抱新形式监督的机构,包括在监管AI过程之中使用AI。这种监管应侧重于减轻技术的影响,而不是对技术本身进行微观管理。

各国AI监管进展与异同点

对比2023年主要国家的AI监管进展与具体政策,可以发现治理思路仍存较大差异,甚至在美欧发达经济体之间,不同点也多过相似点。

1、共同点

各方在AI监管原则上主要有五方面共同点:一是强调透明度、可追溯性与可解释性;二是强调数据保护、隐私与数据安全;三是强调挑战或纠正AI决策,识别并管理相关风险;四是禁止偏见或歧视,并追究人类责任;五是禁止滥用技术及非法活动,并保证人类知情权。

2023年10月末,美国发布《关于安全、可靠和可信的AI行政令》;12月初,欧盟就《人工智能法案》达成协议。二者具有一些相似之处,都采取了基于风险的监管原则,都较为关注高风险AI系统并制定了具体的监管准则,针对新出现的生成式AI技术引入了对基础模型的披露或测试要求。

2、不同点

相对而言,美国采取了一种去中心化、针对具体行业、非强制性的监管方式。

去中心化体现在监管架构上,行政令利用现有机制的权力,指示政府各部门对各自领域的AI安全风险进行评估与制定标准,而没有设立新的法规或新的监管机构。比如,如果AI被用于消费者欺诈,则由美国联邦贸易委员会负责监管。

非强制性体现在监管方式上,行政令并没有规定具体的执行条款,而且目前为止联邦层级的监管都是通过非限制性的行政指令与企业自愿承诺推动,而非立法手段推动。监管的侧重点方面,行政令主要关注AI涉及的安全问题,尤其是国家安全,此外还关注通过吸纳人才加强AI技术创新与竞争力。

许多专家认为,通过行政指令进行监管虽然具有法律效力,但仅限于国会已经批准的权限,国会需要完成联邦层级的立法。主要理由有三点:

第一,行政令监管无法覆盖全部领域,尤其在隐私保护方面,除非国会立法,否则行政令作用有限;

第二,有些州已经各自推动AI监管立法,但各州分而治之可能导致规则不一致,给企业造成合规困难,也可能会在公众层面造成混乱;

第三,总统换届可能将现有的行政令全盘推翻。

大多数分析预测,考虑到大选临近、国会内部持续的政治两极分化、功能严重失调以及美国历来偏向市场导向的自由放任监管方式,短期美国国会不太可能通过任何有意义的AI立法。

欧盟一直以来都在数字科技监管方面走得更快,对AI技术的监管也是如此。整体而言,欧盟AI法案采取了一种全面、横向、基于风险的监管方式。

监管架构上,欧盟AI法案采取了自上而下的双重监管结构,欧盟层级将设立人工智能办公室以监督最先进AI模型标准与测试,成员国层级的市场监督机构则负责执法。

监管范围上,并未区分具体行业,而是对AI技术在具体应用场景的风险进行分级并采取相应的举措,并对AI系统的提供者和使用者规定了复杂细致的要求与义务。

监管严厉程度上,相比美国,欧盟更倾向使用“大棒监管”,比如法案中包含了若干惩罚性条款。

不过,欧盟的AI监管政策还面临着诸多挑战。

首先,部分阻力来自成员国内部的分歧。草案谈判期间,法国和德国就为保护本土AI企业的竞争力而反对对基础AI模型进行全面监管,倾向于通过非强制性的行为准则进行自我监管。欧盟委员会为保全整个法案最后作出了妥协,在草案中对基础模型实施分层监管的办法,总体上削弱了监管强度。

其次,法案距离全面实施至少还有两年,然而技术发展日新月异,到那时法案是否仍对新技术具有适用性仍未可知。

再次,法案的具体实施效果也可能在各成员国中大打折扣。

其他国家中,英国更倾向于利用现有制度监管AI技术,日本正在起草非约束性的AI指导方针,两个国家都避免采取过于约束性的手段以促进技术创新。

中国同样走在立法监管AI的前列。卡内基国际和平研究院研究文章提出,中国采取了一种较为分散、垂直、迭代的监管方式。

分散、垂直体现在监管范围上,对技术的特定应用或表现形式进行针对性监管,包括推荐算法、深度合成技术与生成式AI技术。

监管方式偏向迭代,即通过新法规来完善监管机制或扩大监管范围,这种方式有利于监管跟上技术进步速度,但迭代过程中可能会让企业面临合规方面的困惑。

此外,监管侧重点在于算法和数据的使用。

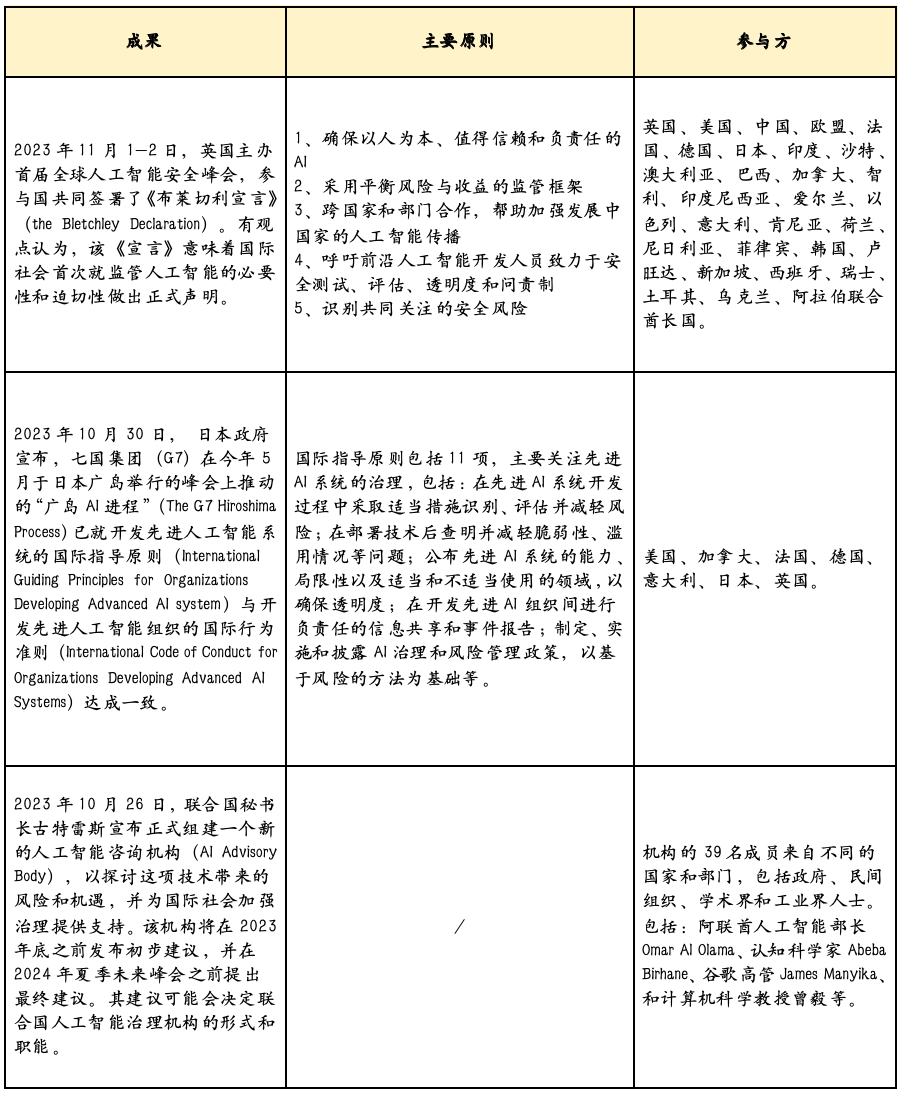

全球AI治理合作进展与展望

1、全球合作进展缓慢

全球层面,2023年并未出现针对AI监管或治理而构建的实质性机制或政策,大多数都是非约束性的指导原则。总体来看,全球AI监管合作进展缓慢。这是因为人工智能政策与地缘政治、经济竞争日益交织,各国在协商过程中不可避免地会产生利益冲突。

2、AI竞合中的中美欧

有专家认为,在全球AI合作治理缺席的情况下,中美欧三方主要力量可能会向全球推进各自对人工智能时代的不同愿景、争夺对未来技术的控制权并扩大自身在数字世界的势力范围,其他国家则面临进入哪个势力范围的选择。

由于欧盟法案的域外适用性以及辐射全球的“布鲁塞尔效应”,有专家建议美国通过美欧贸易与技术委员会(TTC)与欧盟加强监管合作、对齐监管原则。还有专家认为,美欧应与中国在AI监管方面加强接触、学习中国经验并探索各方能否就AI监管达成全球共识。

3、全球合作的必要性与政策建议

有观点提出,由于AI技术的扩散不受国界限制,AI模型一经发布便可无处不在,破碎的监管方式必然产生漏洞与风险,因此建立全球范围的AI监管框架势在必行。理想的治理原则包括注重事前预防而非事后补救,并保持反应的灵活敏捷。

目前对全球AI监管合作的争议点之一在于合作应该基于怎样的机制。目前比较突出的建议试图复制现有的多边机构:联合国秘书长古特雷斯等人呼吁建立AI领域的“国际原子能机构”(IAEA for AI),像国际原子能机构监测核技术一样监测AI技术发展;英国AI安全峰会则建议成立AI领域的“政府间气候变化专门委员会”(IPCC for AI),即建立一个独立的、由专家领导的机构,公正、客观、及时地向政府通报AI能力现状,并对未来情景做出基于证据的预测,以避免利益冲突。

不过,上述建议均在不同程度遭到了技术专家的批评。综合多位专家意见来看,现有机制本身并不足够有效,且由于AI技术快速迭代、广泛扩散、威胁方式不确定、训练基于虚拟数据等特殊性以及其主要由大公司而非政府掌控,与气候变化或核扩散问题有显著区别,现有机制的监管逻辑并不能适用AI技术。

有专家认为,只有在建立可以让企业和各国政府都承担责任的规则法律的前提下,国际监管机构才可能发挥作用,因此各国政府应该首先敲定监管规则的先决条件和具体内容,并且就监管的首要原则达成一致,然后再让机构进行监管。另外,新的合作机制需要建立在对AI发展及治理原则的共识之上,需要保持监管规则的灵活敏捷,且需要妥善应对地缘政治方面的挑战。

第一财经获授权转载自微信公众号“中国金融四十人论坛”。

隔夜英伟达飙升超7%,股价重新站上900美元大关,相关概念股表现活跃

截至发稿,中富通涨超9%,诚迈科技、扬杰科技、赛腾股份等跟涨。3月13日早盘,英伟达概念股走高。截至发稿,中富通涨超9%,诚迈科技、扬杰科技、赛腾股份等跟涨。隔夜美股市场上,英伟达大涨超7%,最新市值2.3万亿美元。3月5日,英伟达超越沙特阿美,成为全球市值第三大公司,仅次于苹果和微软。截至目前,微软和苹果的总市值分别为3.09万亿美元、2.67万亿美元。锤子财富2024-03-13 10:29:000000WHO呼吁在公共健康领域慎用AI,存在这些忧虑

此类大型语言模型工具包括ChatGPT等许多其他模仿理解、处理和产生人类交流的平台。当地时间16日,世界卫生组织(WHO)发声明呼吁谨慎使用人工智能(AI)生成的大型语言模型工具(LLM),以保护和促进人类的福祉、安全和自主性,并维护公共健康。锤子财富2023-05-17 09:32:440000海关总署:一季度我国外贸进出口同比增长4.8% 外贸开局稳中向好

据海关统计,一季度我国货物贸易进出口总值9.89万亿元人民币,同比增长4.8%。其中,出口5.65万亿元,同比增长8.4%;进口4.24万亿元,同比增长0.2%。4月13日,海关总署新闻发言人、统计分析司司长吕大良在发布会上通报今年一季度我国外贸进出口情况。0000新加坡总理李显龙将于5月15日辞去总理一职

新加坡总理公署15日宣布,李显龙将在下个月15日辞去总理一职,副总理兼财政部长黄循财将在当天20时宣誓就任总理。据新加坡总理李显龙社交媒体平台发布的消息,他将于5月15日辞去总理一职。新加坡总理公署15日宣布,李显龙将在下个月15日辞去总理一职,副总理兼财政部长黄循财将在当天20时宣誓就任总理。0000